آموزش ساخت فایل robots.txt برای لاراول

0 نظر

شنبه 06 مرداد

مطالعه: 20 دقیقه

سئو و بهینه سازی

robots.txt یک فایل متنی ساده ولی قدرتمند است که می تواند در آزاد کردن قدرت مدیریت وب سایت تاثیر زیادی داشته باشد. این فایل در ریشه سایت شما قرار می گیرد و می تواند به راحتی از استاندارد حذف روبات ها پیروی کند. به این صورت که اگر آدرس وب به شکل WWW.Yourdomain.Com باشد، آدرس دوم آن به شکل WWW.Yourdomain.Com/robots.txt خواهد بود، اما مفهوم دقیق و بیشتر از کارایی فایل robots.txt را در ادامه مورد بحث قرار خواهیم داد و در صورت تمایل می توانید با مراحل موجود در این راهنما یک فایل robots.txt برای لاراول بسازید.

مزیت های استفاده از فایل robots.txt برای لاراول

همواره در پروژه های لاراول به نکاتی در مورد اهمیت ساخت و استفاده از فایل های robots.txt برخورد کرده ایم که تعدادی از مهم ترین آن ها در ادامه برای شما بازگو شده است:- کنترل دسترسی ربات های خزنده

- حفظ حریم خصوصی برای اطلاعات حساس

- ارتقا سرعت ایندکس

- تاثیر مثبت بر سئو

- کاهش بار سرور

- جلوگیری از تداخل صفحات در وب

ساخت فایل robots.txt در Laravel با 5 مرحله ساده

در شروع ساخت و استفاده از فایل robots.txt باید در نظر داشته باشید که به دامنه ریشه دسترسی کامل داشته باشید در صورت عدم اطلاع از این دسترسی می توانید از ارائه دهنده میزبانی وب خود سوال کنید.1- ساخت فایل robots.txt

شما می توانید از هر ویرایشگر متنی برای ایجاد فایل robots.txt استفاده کنید، زیرا مهم ترین نکته نحوه ساخت و محل فایل گذاری خواهد بود. برای شروع باید فاکتورهای مهم زیر را در نظر بگیرید:- ریشه دامنه: WWW.Yourdomain.com/robots.txt

- زیر دامنه: Page.Yourdomain.com/robots.txt

- پورت های غیر استاندارد: WWW.Yourdomain.com:881/robots.txt

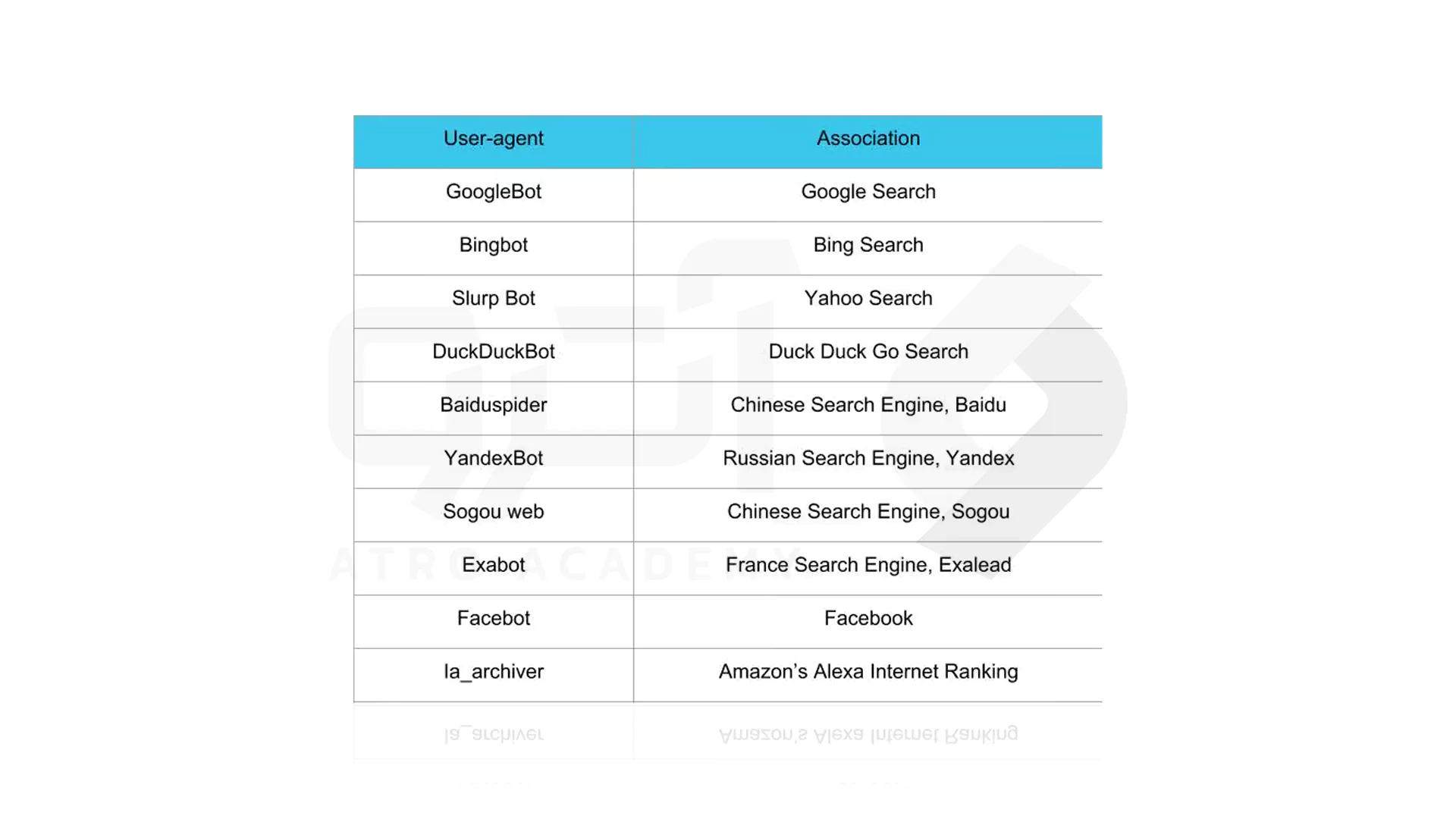

2- تعیین User-agent

همان طور که اطلاع دارید User-agent یک عامل کاربر برای صدور اجازه برای خزنده های وب یا موتورهای جستجو می باشد که در این مرحله باید User-agent را در فایل robots.txt تنظیم کنید. بنابراین ابتدا می توانید با کمک گرفتن از تصویر راهنما زیر از چند خزنده و همچنین ارتباط آن ها مطلع شوید.

امتحان کردن یکی از 3 روش زیر برای تنظیم User-agent در فایل robots.txt برای شما کاربردی خواهد بود:

- روش اول: ایجاد یک عامل

# Example of how to set user-agentUser-agent: DuckDuckBot- روش دوم: ایجاد بیش از یک عامل

#Example of how to set more than one user-agentUser-agent: DuckDuckBotUser-agent: Facebot- روش سوم: تنظیم تمام خزنده ها به عنوان کاربر

#Example of how to set all crawlers as user-agentUser-agent: *3- تنظیم قوانین برای فایل robots.txt

طبق ساختار موجود فایل های robots.txt به صورت گروهی خوانده می شوند و به این منظور باید گروه، کاربر و دستورالعمل هایی را برای پیروی مشخص کنید که در آن فایل ها و یا دایرکتوری هایی که کاربر اجازه و یا عدم اجازه به دسترسی دارد مشخص شود. نمونه هایی از قوانین قابل وضع برای این فایل در ادامه ذکر شده است که می توانید از آن ها استفاده کنید:- قانون Disallow

- قانون Allow

- نقشه Sitemap

- نحوه تنظیم قوانین

# Example of how to block DuckDuckBotUser-agent: DuckDuckBotDisallow: /#Example of how to block more than one user-agentUser-agent: DuckDuckBotUser-agent: FacebotDisallow: /#Example of how to block all crawlersUser-agent: *Disallow: /# ExampleUser-agent: *Disallow: /https://page.yourdomain.com/robots.txt# ExampleUser-agent: *Disallow: /images/# Allow example to allow all crawlersUser-agent: *allow:# Disallow example to allow all crawlersUser-agent: *Disallow:4- آپلود فایل robots.txt

با توجه به ماهیت فایل های robot.txt منطقی است بدانیم که وب سایت ها به صورت خودکار این فایل را ندارند و باید آن را آپلود کرد. آپلود فایل robots.txt به ساختار فایل وب سایت و محیط میزبانی وب شما بستگی دارد، اما در حالت کلی باید در فهرست اصلی وب سایت آپلود گردد.5- بررسی کارکرد فایل robots.txt

روش های زیادی برای بررسی نحوه کارکرد درست فایل robots.txt وجود دارد که تعداد از آن ها استفاده از موارد زیر می باشد:- Google’s robots.txt Tester

- robots.txt Validator and Testing

- Ryte’s robots.txt Test